꾸스코딩

[논문리뷰] Reasoning on Graphs: Faithful and Interpretable Large Language Model Reasoning, ICLR'24 본문

[논문리뷰] Reasoning on Graphs: Faithful and Interpretable Large Language Model Reasoning, ICLR'24

꾸스코딩 2025. 2. 28. 22:08안녕하세요 :-)

3번째 논문으로 돌아왔습니닷!

벌써 2월 중순이라니 시간이 너무 빠르네요 ,,

https://arxiv.org/abs/2310.01061

Reasoning on Graphs: Faithful and Interpretable Large Language Model Reasoning

Large language models (LLMs) have demonstrated impressive reasoning abilities in complex tasks. However, they lack up-to-date knowledge and experience hallucinations during reasoning, which can lead to incorrect reasoning processes and diminish their perfo

arxiv.org

오늘도 논문 제목부터 한 번 살펴볼까요?

Reasoning on Graphs: Faithful and Interpretable Large Language Model Reasoning

▶ Faithful and Interpretable

오늘은 비교적 간단한데요! faithful과 interpretable이라는 키워드를 사용한 것을 보니 논문을 읽어보면서

어떻게 faithful과 interpretable을 보장하는지 살펴보면 좋을 것 같네요!

Introduction (Background, Motivation, Contribution)

Background는 해당 논문을 이해하기위해 논문에 작성되어있는 간단한 개념들을 정리한 파트입니다.

Motivation은 기존 연구가 어떻길래 해당 연구가 필요한지 즉, 연구 동기에대해 정리한 파트입니다.

Contribution은 motivation을 어떻게 해결하였는지에대한 내용을 정리한 파트입니다.

◼︎ Background

- KGQA + w/ LLM

- Semantic-parsing

- 자연어 형태의 질문을 structural query(SPARQL)로 변환하여 지식그래프(KG)를 대상으로 query를 실행해 정답 반환

- Retrieval-augmented

- 지식그래프(KG)로부터 relative fact들을 retrieve하는 것을 목적으로 하여 reasoning 성능을 향상하는 방법

- Semantic-parsing

◼︎ Motivation

- LLM의 reasoning 능력은 뛰어나지만, up-to-date knowledge가 잘 없고 hallucination 발생

∴ Factual knowledge에 해당하는 Knowledge Graph ⨂ LLM을 결합하여 LLM의 단점 해결 도모 - 기존 KGQA + w/LLM 방법론들의 단점

- SP-based : 더 정확하고 interpretable하지만, 생성된 query가 실행 불가할 수도 있고 no answer일 수도 있음

- RA-based : SP보다 flexible하지만 KG의 structural information 무시

◼︎ Contribution

- Reasoning-on-Graphs(RoG) 제안 : planning-retrieval-reasoning framework

⇒ 2가지 task에 대하여 최적화 되어있음- Planning optimization: KG로부터 지식을 distill하여서 LLM으로 하여금 faithful relation path를 plan으로 제공하게끔 함

- Retrieval-reasoning optimization: Retrieved path들 기반으로 faithful reasoning을 가능하게끔 하고 interpretable한 결과 생성

Methods

해당 파트에서는 방법론에대해 설명하는 파트입니다.

0️⃣ Overview

- Planning - Retrieval - Reasoning framework

- Relation path를 plan으로 간주! → entity는 dynamic하게 변하지만, relation은 stable

- 수식 표현

- Optimization framework: relation path를 plan으로 간주하는 것은 장점이지만 LLM이 KG와 친하지 않다는 문제점!

① Planning optimization

[목표] KG로부터 knowledge를 distill하여 LLM이 faithful relation paths를 plan으로 생성

⇒ Faithful relation path의 posterior distribution과 함께 KL divergence를 minimize

② Retrieval-reasoning optimization

[목표] LLM이 retrieved reasoning path들을 기반으로 reasoning을 잘 하는 것

⇒ FiD framework를 따름

✳︎ 두 optimization을 합한 최종 objective function

1️⃣ Planning module

- LLM을 활용하여 relation path 생성

- 이에따라 해당 optimization 달성

2️⃣ Retrieval-Reasoning module

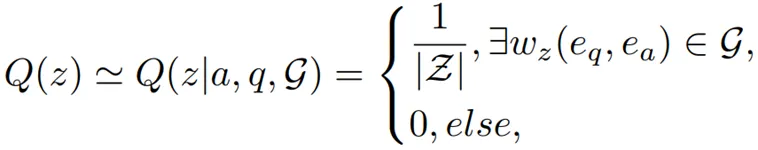

- Retrieval: [목표] KG로부터 reasoning path $w_z$ 를 잘 retrieve 하는 것

- 이렇게 가져온 reasoning path들이 정답을 majority voting으로 바로 가져올 수 있지만, 여전히 질문과 관련이 없거나 noise를 가지고 있을 수 있음

∴ Reasoning 단계가 필요! - Reasoning

- Optimization

- 이렇게 가져온 reasoning path들이 정답을 majority voting으로 바로 가져올 수 있지만, 여전히 질문과 관련이 없거나 noise를 가지고 있을 수 있음

Experiments

해당 파트에서는 실험 세팅 및 결과에대해 설명하는 파트입니다.

- 실험 세팅

- 데이터셋 : WebQSP, CWQ

- Baseline : Embedding/RA method/ SP method/ LLm / LLM+KG

- 평가지표 : Hits@1, F1

- Implementations for RoG

- LLM : instruction tuing된 LLaMA2-Chat-7B

- 학습 데이터: WebQSP, CWQ training set의 일부

- 학습 에폭: 3epoch

- 각 질문마다 beam search를 활용하여 top-3 relation paths 생성

- LLM : instruction tuing된 LLaMA2-Chat-7B

- 실험 결과

- Q1) KGQA performance

⇒ Table1을 통해 전반적으로 RoG가 기존의 SoTA 모델의 성능을 뛰어넘음 - Q2) Plug-and-Play RoG Planning Module

⇒ Table 3을 통해 RoG의 planning module을 활용하면 기존 LLM만 사용할때보다 성능 향상을 보여줌 - Q3) Fiathful reasoning and interpretable results

⇒ k 값의 변화를 주면서 실험을 해본 결과 k 값이 늘어날 수록 해당 relation path가 answer를 cover할 확률은 늘어나지만, noise 또한 증가 ∴ 해당 저자들은 k=3으로 설정 - Ablation study

- Q1) KGQA performance

🐹 SUM UP

이렇게 3번쨰 논문을 정리해보았는데요!

생각보다 다시 돌아오는데 너무 오래 걸려서 좀 민망하네요,,ㅎ

아무튼 해당 논문은 Llama-2-7B를 instruction fine-tuning하여 최종 inference 단계에서는 relation path생성과 reasoning 이렇게 LLM을 2번 call하여 질문에대한 최종 답변을하는 방법론을 소개하는 논문입니다.

해당 KGQA task에서는 꽤나 사랑받고 있는 논문이라고 생각해요! 인용횟수를 봐도 많은 사람들이 이 논문으로부터 다양한 insight를 얻는 듯해요.

꼭 KGQA task가 아니더라도 관련해서 다양한 insight 혹은 궁금한 점이 있으면 댓글로 남겨주시면 감사하겠습니다:-)

그럼 최대한 빨리!! 다음 논문 정리로 찾아뵙도록 하겠습니다아